Renseigner la phrase de passe pour déchiffrer le disque au démarrage peut très rapidement devenir pénible. Sur les systèmes modernes, il y a une puce matérielle dédiée à la sécurité, appelée TPM, qui peut stocker un secret permettant de déchiffrer automatiquement votre disque.

Cet article explique comment mutualiser simplement les bannissements entre les noeuds d'un cluster afin de bannir préventivement les tentatives d'attaque sur le service SSH.

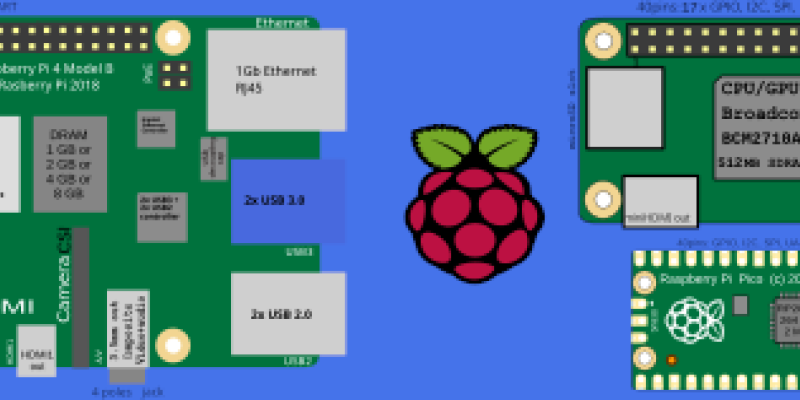

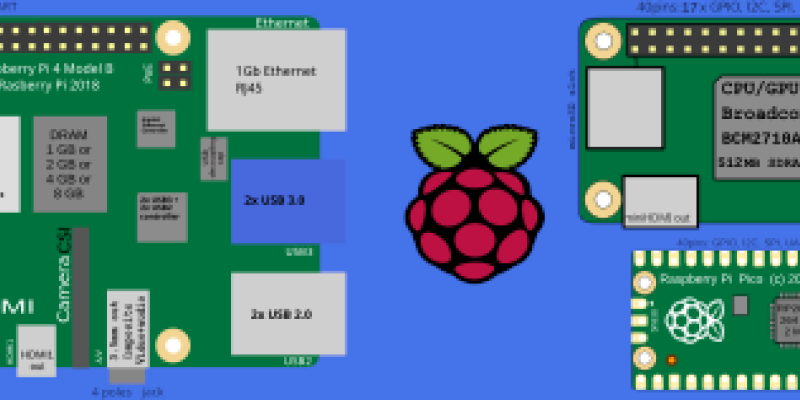

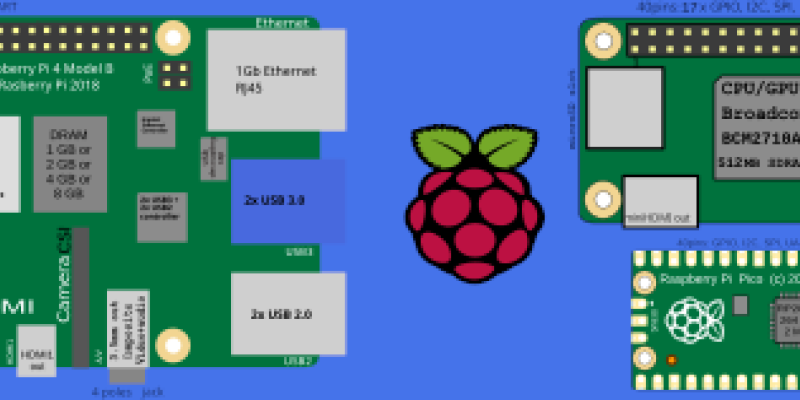

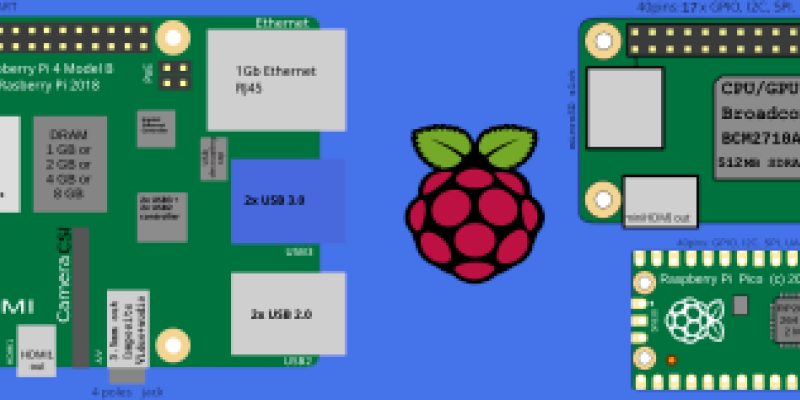

Remplacer la carte SD par un disque dur SSD sur un raspberry pi 4

Nous allons monter un cluster k3s de trois noeuds sur des raspberrypi 4 8G pas à pas.

Affichage des stats système sur un écran oled-ssd1306 128x32 via le bus i2c sur raspberry-pi

Comment installer docker provenant du dépôt docker afin de toujours avoir la dernière version sur son raspberry-pi

Comment installer le paquet netdata provenant du dépôt netdata afin de toujours avoir la dernière version sur son raspberry-pi

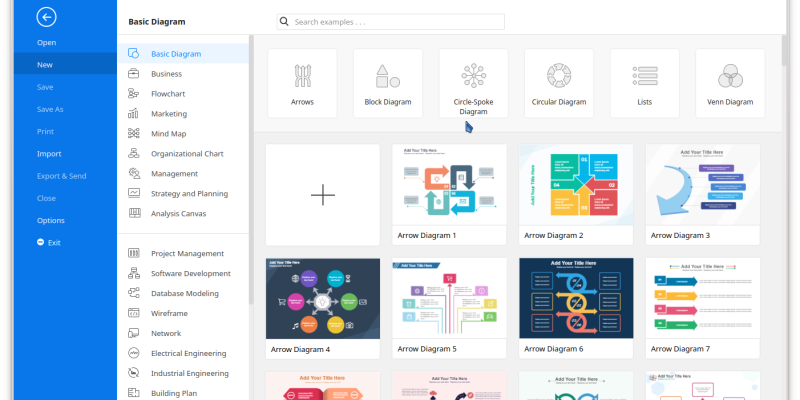

Pour la petite histoire, edrawmax est un logiciel multi-plateforme permettant de créer facilement des diagrammes à partir d'une multitude de modèles.

Le passage de Fedora 33 à Fedora 34 s'est bien passé avec quelques problèmes tout à fait mineurs.

Avec la sortie de CentOS 8, j'ai eu le besoin de déployer facilement la distribution et de construire des paquets personnels pour l'enrichir. Le déploiement sera fait via un cobbler existant et la construction de RPM avec un système Koji déjà opérationnel.

Les images officielles docker pour CentOS sont mise à jour à chaque nouvelle version, mais même la version latest nécessite rapidement une mise à jour.

Bien qu'on puisse lancer la mise à jour dans les premières lignes de notre Dockerfile, cela alourdi inutilement l'image finale (empilement), alors qu'il suffirait de disposer d'une image déjà à jour.

Il existe plein d'utilitaires géniaux qui font ça très bien, mais est-ce vraiment si compliqué de le faire à la main ?

Avec l'arrivée de netdata sur fedora et epel, l'installation est maintenant trivial

Ansible® est un outil Open Source d'automatisation informatique qui automatise le provisionnement, la gestion des configurations, le déploiement des applications, l'orchestration et bien d'autres processus informatiques manuels.